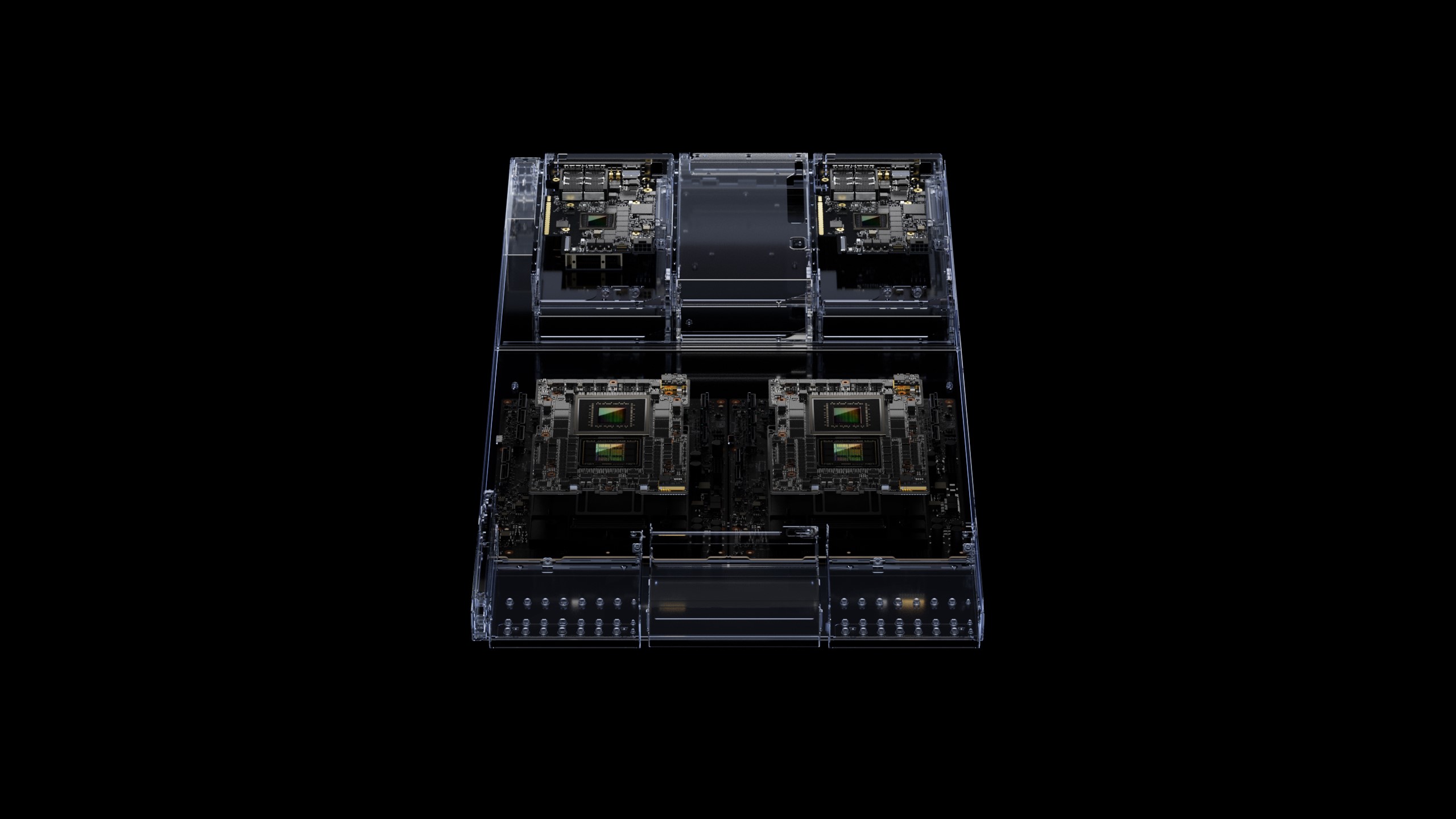

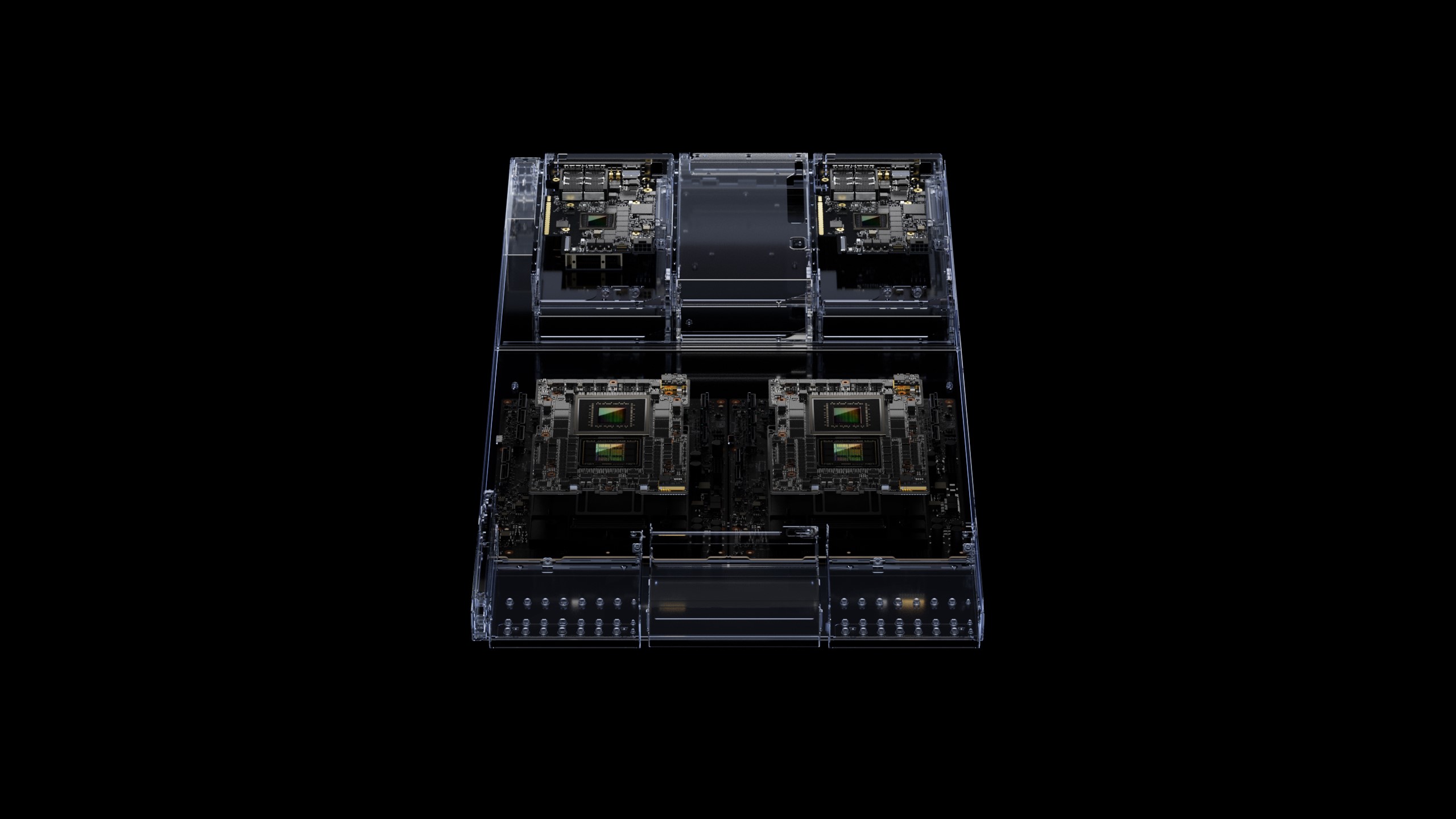

▲GH200 그레이스 호퍼 슈퍼칩(이미지:엔비디아)

HBM3e 탑재·다중 GPU 연결 기능 지원

주요 시스템 제조사, 2024년 2분기 적용

생성AI가 산업과 시장 판도를 뒤흔들고 있는 가운데 AI 서버 시장을 주도하는 엔비디아가 차세대 AI 지원 플랫폼을 선보였다.

AI 컴퓨팅 기술 분야의 선두주자인 엔비디아가 가속 컴퓨팅과 생성형 AI를 위한 차세대 엔비디아 GH200 그레이스 호퍼 플랫폼(NVIDIA GH200 Grace Hopper platform)을 10일 발표했다.

GH200 그레이스 호퍼 플랫폼은 세계 최초로 HBM3e 프로세서가 탑재된 새로운 그레이스 호퍼 슈퍼칩을 기반으로 한다. 대규모 언어 모델, 추천 시스템, 벡터 데이터베이스를 비롯해 전 세계적으로 가장 복합한 생성형 AI 워크로드를 처리할 수 있도록 개발됐으며, 다양한 구성으로 제공될 예정이다.

현 세대 제품보다 최대 3.5배 많은 메모리 용량과 3배 높은 대역폭을 제공하는 듀얼 구성은 144개의 Arm 네오버스 코어, 8페타플롭의 AI 성능, 282GB의 최신 HBM3e 메모리 기술을 갖춘 단일 서버로 구성된다.

엔비디아 창립자 겸 CEO인 젠슨 황(Jensen Huang)은 “급증하는 생성형 AI의 수요를 충족하기 위해 데이터센터에는 전문적인 요구 사항을 갖춘 가속화된 컴퓨팅 플랫폼이 필요하다”며 “새로운 GH200 그레이스 호퍼 슈퍼칩 플랫폼은 탁월한 메모리 기술과 대역폭을 통해 처리량을 개선하고, 성능의 저하 없이 GPU를 연결해 성능을 통합한다”고 말했다.

새로운 플랫폼에 사용된 그레이스 호퍼 슈퍼칩은 엔비디아 NV링크(NVLink)로 추가 슈퍼칩과 연결할 수 있으며, 이들이 함께 작동해 생성형 AI에 사용되는 거대한 모델을 배포할 수 있다. 이러한 고속 기술은 GPU가 CPU 메모리에 완전히 액세스할 수 있도록 지원해 듀얼 구성 시 총 1.2TB의 빠른 메모리를 제공한다.

HBM3e 메모리는 기존 HBM3보다 데이터 전송 속도가 50% 빠르며, 초당 총 10TB의 대역폭을 제공한다. 이를 통해 새로운 플랫폼에서 이전 버전보다 3.5배 용량이 큰 모델을 실행할 수 있으며, 3배 빠른 메모리 대역폭으로 성능을 개선할 수 있다.

선도적인 제조업체들은 이미 이전에 발표된 그레이스 호퍼 슈퍼칩을 기반으로 한 시스템을 선보이고 있다. HBM3e가 탑재된 차세대 그레이스 호퍼 슈퍼칩 플랫폼은 기술의 도입을 확대하기 위해 올해 초 컴퓨텍스에서 공개된 엔비디아 MGX서버 사양과 완벽하게 호환된다. 모든 시스템 제조업체는 MGX를 통해 100가지가 넘는 서버 변형에 그레이스 호퍼를 추가할 수 있다.

엔비디아측에 따르면 주요 시스템 제조업체는 2024년 2분기에 GH200 그레이스 호퍼 플랫폼을 기반으로 한 시스템이 제공될 것으로 예상했다.